Da un lato la visione “americana”, contraria a ogni forma di limitazione, dall’altro quella “europea”, più restrittiva e attenta al rispetto della dignità altrui. Sono questi i due “poli” di un ideale continuum su cui si posizionano le riflessioni sui limiti della libertà di espressione. E i colossi di internet e social network come Google, Facebook, Youtube e Twitter, dove si collocano? Le misure di prevenzione dell’hate speech da loro proposte sono valide? Quando e come può intervenire lo Stato?

di Cecilia Siccardi

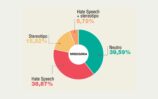

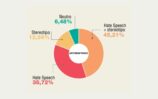

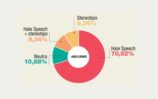

Il progetto di Vox “La Mappa dell’Intolleranza” dimostra la crescente diffusione del linguaggio dell’odio su Twitter e, in generale, sui social network. I risultati del progetto possono rappresentare un punto di partenza per riflettere, da un punto di vista giuridico, sulle modalità più idonee a contrastare la diffusione dell’hate speech online. Si tratta di un tema delicato, poiché tocca nel profondo un principio cardine del nostro ordinamento costituzionale: la libertà di espressione e i suoi limiti.

Libertà di espressione: due visioni a confronto

Sui limiti della libertà di espressione si scontrano storicamente due visioni, una cosiddetta “americana” e un’altra che potremmo definire “europea”. La prima ripudia ogni tipo di censura o limitazione ed è orientata al principio del mercato delle idee. In altre parole, secondo questa tesi le idee negative non si contrastano con la censura, ma attraverso il confronto con altre idee positive. La visione europea è, invece, più restrittiva: la libertà d’espressione ha dei limiti che coincidono con la protezione di diritti e di interessi costituzionalmente garantiti. Nel caso del linguaggio dell’odio, tale limite potrebbe coincidere, dunque, con la “dignità” altrui. È una concezione della libertà di espressione che trova origine nella storia europea: le prime leggi volte a limitare il linguaggio dell’odio, infatti, sono state adottate per evitare il ripetersi delle violazioni di diritti umani avvenute durante i regimi totalitari (ad esempio la legge Scelba e la legge Reale – Mancino).

Twitter, Facebook, Google, Youtube, tra visione americana ed europea

Tra queste due grandi e differenti visioni della libertà di espressione, l’americana da un lato e l’europea dall’altro, si posizionano i colossi di internet e i social network. Soggetti come Google, Facebook, Twitter, Youtube, infatti, provengono da una tradizione americana, ma operano in Paesi con un approccio europeo più restrittivo nei confronti del linguaggio dell’odio.

Inizialmente i social si sono comportati in tutto e per tutto secondo il modello americano – hands off, letteralmente “giù le mani”, in italiano – rifiutando ogni censura nei confronti dei loro utenti. In un secondo momento, invece, le grandi società che governano internet hanno iniziato a comprendere che la diffusione del linguaggio dell’odio poteva rappresentare un problema: non era la violazione della dignità delle persone a preoccuparli, quanto piuttosto l’abbandono di molti utenti da social e piattaforme, determinato proprio dalla diffusione della violenza. Per questa ragione Facebook, Youtube e – solo più recentemente – Twitter si sono dati delle regole, elaborando degli standard per contrastare la diffusione del linguaggio dell’odio.

Tuttavia, l’approccio delle grandi aziende di internet riguardo alla diffusione dell’hatespeech resta alquanto ambiguo. Pur essendosi dotati di standard restrittivi in stile “europeo”, infatti, sembra che tali regole siano piuttosto applicate “all’americana”. In altre parole, gli standard non sempre vengono rispettati. A dimostrazione di ciò basta guardare i dati: secondo l’indagine svolta dall’associazione Carta di Roma su Facebook, ad esempio, solo un terzo dei contenuti segnalati vengono effettivamente rimossi dal social network di Mark Zuckerberg.

Hatespeech on line: chi decide?

L’inefficacia delle regole imposte dai social network ci induce a riflettere su un’altra questione: chi sono i soggetti competenti a definire i casi in cui un’espressione rientra nel cosiddetto “hate speech”? Chi decide quali contenuti devono essere rimossi dai social? Le grandi aziende di internet o gli Stati? Si tratta di una questione tutt’altro che banale. Per fare un esempio concreto, basta ricordare un episodio abbastanza recente. Nel 2012 Youtube, che si è dotato di regole sul linguaggio dell’odio piuttosto restrittive, ha diffuso un video su Maometto (intitolato “Innocence of Muslims”), giudicato dalla comunità islamica blasfemo, provocando proteste in Egitto e Libia. A causa dei disordini, l’allora presidente dell’Egitto, Mohamed Morsi, e il suo omologo della Casa Bianca, Barack Obama, hanno chiesto a Youtube di rimuovere il video. Tuttavia, Youtube ha deciso di non intervenire, affermando che i propri standard impongono la rimozione di contenuti discriminatori contro comunità religiose, ma nulla vietano rispetto a video satirici nei confronti di una “persona”, Maometto. La questione è arrivata fino al consiglio delle Nazioni Unite, dove i presidenti di Stati Uniti ed Egitto hanno fondato i loro discorsi su due visioni opposte della libertà di espressione. L’esempio è emblematico, perché dimostra come, in assenza di regole precise, gli attori di internet rischiano di avere l’ultima parola, anche rispetto alle massime cariche dello Stato.

E quindi?

Quanto appena ricordato, mostra come siano necessarie normative che siano in grado di cogliere l’essenza del web, come spazio fluido trasnazionale e senza confini, il quale non può essere regolato efficacemente solo in base alle scelte di un singolo stato. E’ necessario, quindi, coinvolgere gli attori principali – nazionali e internazionali – che governano internet, al fine di proporre una policy uniforme di rimozione dei contenuti contrari agli standard prescelti. E’ inoltre importante prevedere, oltre ad azioni di contrasto, anche attività di sensibilizzazione e prevenzione, volte sia a colmare il gap digitale, sia a trasmettere la cultura del rispetto dei diritti dell’altro. In questo senso, merita di essere richiamata l’iniziativa promossa dalla Presidente della Camera Laura Boldrini, che ha istituito la Commissione “Jo Cox” sull’intolleranza, la xenofobia, il razzismo, sull’odio e sulla violenza on line”, la quale al fine di contrastare episodi di violenza su internet, coinvolge un team di esperti e diversi attori del web, a livello nazionale e trasnazionale.